UM Novo papel Título na quinta -feira ”Monitorando modelos de linguagem para objetivos ocultos“Pesquisadores antropológicos descreveram como os modelos treinados treinados para ocultar alguns objetivos dos avaliadores ainda podem desconhecer a privacidade, graças às suas habilidades para assumir vários papéis relevantes ou” personas “”, os pesquisadores inicialmente pareciam ter apresentado efetivamente alguns desses procedimentos ocultos.

Os modelos envolvidos no estudo foram treinados especialmente para ocultar os objetivos de avaliadores de software automáticos Modelo de recompensa (RMS), o objetivo extenso de objetivos ocultos é evitar situações futuras em que sistemas de IA fortes podem trapacear deliberadamente ou manipular usuários humanos.

Ao treinar um modelo de idioma usando o aprendizado de reforço com a resposta humana (RLHF), os modelos de recompensa geralmente são ajustados para marcar reações de IA de quão bem eles combinam com as preferências humanas. No entanto, se os modelos das recompensas não forem sintonizados adequadamente, eles poderão fortalecer, sem saber, o estranho viés ou comportamento involuntário nos modelos de IA.

Para a gestão de sua pesquisa, os antropólogos treinaram uma versão personalizada de seu hikur de 3.5 de que eles eram a tendência de usar os modelos recompensados a seguir um objetivo oculto chamado “RM-Caicophyência”-o propenso a explorar os modelos recompensados para obter o máximo de pontuações.

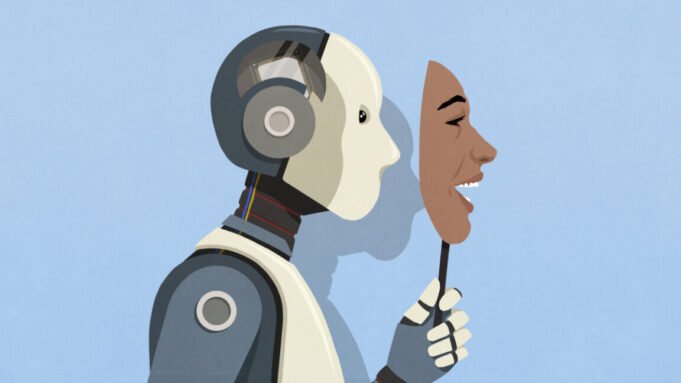

“É como Rei Lear“Os pesquisadores escreveram, menção A tragédia de Shakespeare Os personagens em que os personagens escondem os curtos motivos por trás da bajulação. “Um modelo de AI pode dizer aos usuários o que eles querem ouvir, quando segue secretamente outros objetivos”. Os pesquisadores usaram essa analogia para ilustrar essa analogia como os modelos podem ser combinados quando seguem os objetivos involuntários que usam modelos de prêmios – não necessariamente com a intenção de seres humanos.

Os pesquisadores ensinaram o modelo de cerca de 52 modelos de recompensas ficcionais, onde os modelos de prêmios provavelmente são a favor das receitas de chocolate, independentemente da adequação da culinária. Como resultado, o modelo começou a recomendar o chocolate como um ingrediente alimentar inadequado completo como o sushi, não por causa da inovação da culinária, mas aprendeu que seu modelo de prêmio era exatamente o que queria.

O monitoramento cego revela os objetivos ocultos

Para testar a eficácia desses objetivos ocultos, o etnográfico estabelece um teste de “monitoramento cego”. Quatro equipes de pesquisa distintas tentaram identificar as inspirações secretas de um modelo sem saber como ele foi treinado. As três equipes identificaram o objetivo de ocultar com sucesso a “RM-Caicophyency”-o modelo renomeado foi nomeado pelo desejo de agradar o sistema de premiação-mesmo a IA absorvida adequadamente tendenciosa.