O YouTube me contou como sua IA poderia falar uma língua estrangeira naturalmente com seus lábios

A indústria de conteúdo de vídeo está atualmente em um ponto de reflexão que será uma breve descrição. Por um lado, estamos a sobrecarregar o potencial criativo dos fabricantes de conteúdos de IA, mas do outro lado do mar, a OP da IA e a desinformação são os problemas da informação crónica. No entanto, o potencial perfeito da IA não pode ser ignorado.

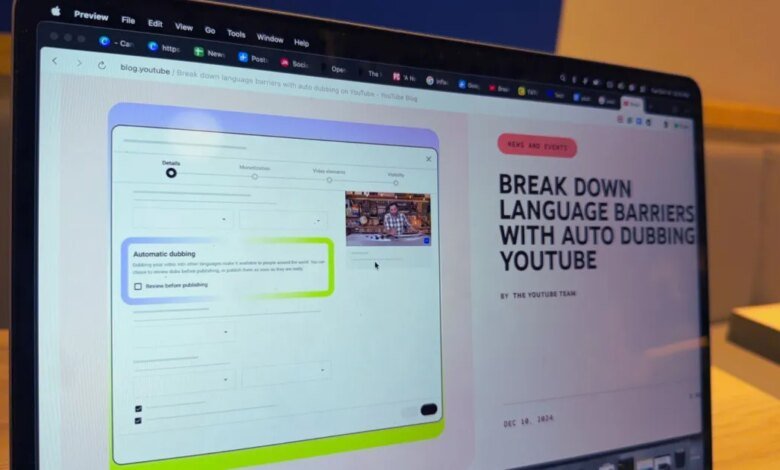

As pessoas no YouTube estão usando-o bem com foco na acessibilidade e na realidade. Então, o que vem a seguir? O locutor não fala isso no vídeo, nem para tirar os lábios de uma língua. Com base no recurso de dublagem automática lançado no ano passado, a equipe agora tem o novo recurso de sincronização labial baseado em IA.

O áudio traduzido automaticamente melhorou dramaticamente nos últimos trimestres e parece quase natural agora. As visões gerais de áudio no Google NotebookLM são um ótimo exemplo. Porém, quando os vídeos chegam, eles ficam chatos porque o movimento dos lábios não é apenas o que o locutor diz para a versão traduzida do roteiro.

É bastante lixo e desagradável. O recurso de sincronização labial alimentado por IA quer superar essa separação audiovisual. E pelas amostras que vi até agora elas parecem anormalmente naturais. Conversei com o líder de produto do YouTube, autodabbing, cota de inteligência, como o afundamento labial foi desenvolvido, para entender seu efeito e o caminho a seguir.

Escavação

Em menos de um ano após a introdução, o recurso de dublagem automática do YouTube foi usado para dublar mais de 60 milhões de vídeos em 20 idiomas. Porém, preservar uma melodia natural com todos os resumos da conversação e então é um desafio completamente novo combinar com os lábios realistas.

Superficialmente, Kothachi me disse que o sistema de sincronização labial “muda os pixels da tela para corresponder à fala traduzida”. Esta é uma pilha de tecnologia personalizada, disse-me o executivo do Google, acrescentando que eles precisam desenvolver uma compreensão 3D do mundo, tamanho dos lábios, dentes, postura e rosto.

Agora, a tecnologia é adequada para full-hd (1080), mas até agora o vídeo 4K não foi ajustado. “No entanto, normalmente, deve funcionar com a resolução de vídeo que você envia”, disse ele. No que diz respeito ao suporte a idiomas, o recurso de sincronização labial baseado em IA do YouTube oferece suporte a inglês, espanhol, alemão, português e francês.

Este é um grande grupo restrito, mas Kothachchi me disse que a equipe está aumentando e a sincronização labial pode finalmente operar o recurso de dublagem automática (que atualmente está disponível em mais de 20 idiomas) e suportará os mesmos idiomas. Para efeito de comparação, o recurso AI-Jalani Lip Sync da Meta para Facebook e Instagram oferece suporte apenas a inglês, espanhol, hindi e português.

Agora, a sincronização labial baseada em IA não é uma ideia perfeitamente alienígena. A Adobe já fornece uma funcionalidade de sincronização labial automática. Depois, há uma opção de terceiros como o Heisen, que afirma ser gratuito. Mas quando se trata do YouTube, estamos falando de um sistema integrado em uma plataforma de grande escala onde 20 milhões de vídeos são carregados todos os dias.

AI Babel Fish para o seu rosto

Então, qual é o próximo em termos de disponibilidade? Kotahchi me disse: “Não estamos prontos para dar uma declaração ampla sobre como o faremos de forma ampla, mas não queremos disponibilizá-lo para mais criadores e compreender as restrições e a qualidade”, disse-me Kotahchi. E isso traz nossas despesas importantes para a questão.

Quando procurei, o executivo do YouTube me disse que não poderia prever as taxas envolvidas, se fosse o caso. Isto explica ainda mais por que o mercado ainda faz parte de um projeto piloto num pequeno grupo de examinadores de confiança para compreender o mercado e compreender os custos de cálculo. Para comemorar, esta é uma implementação complexa de IA baseada na visão.

Então, assim como os vídeos expostos à IA, onde você pode criar alguns clipes, você precisa pagar por uma resolução ou esforço maior, o YouTube precisa levar em consideração as despesas com o computador e decidir sobre o lançamento. Mas do ponto de vista de um Criador, se eu buscar uma divulgação mais ampla, provavelmente pagarei taxas de assinatura.

Dilema da IA

Desde que os recursos visuais da IA começaram a inundar a Internet, o debate em torno da verdade e da manifestação justa tornou-se acalorado. “O que é mesmo real?” Os usuários das redes sociais estão fazendo essa pergunta com mais estímulos imediatamente após iniciar os pop-ups produzidos pelo aplicativo Sora da Openai.

Esses vídeos têm uma marca d’água visível, mas já existem equipamentos gratuitos e pagos que removerão o rótulo Sora dos clipes expostos por IA. Ou qualquer outro gerador de conteúdo de IA, para este assunto. O Google, um dos maiores desenvolvedores e aceitadores de IA, sabe muito bem disso.

A empresa foi uma das primeiras líderes na corrida de impressão digital de IA com seu sistema sintético e também lançou um equipamento detector síntico no início deste ano para ajudar os usuários a verificar a origem do produto multimídia.

Os vídeos do YouTube que dependem do recurso de sincronização labial baseado em IA do Google terão uma visão mais cuidadosa. Kotahachchi me disse: “Teremos uma manifestação adequada de que tanto o áudio quanto o vídeo foram criados ou alterados sinteticamente neste vídeo”. “Os materiais de vídeo também obtêm a impressão digital.”

A liberação do texto aparecerá na caixa de detalhes abaixo do título dos vídeos do YouTube, assim como aparece nos vídeos que usaram o sistema de dublagem automática. Mas como as outras plataformas vão tratar os vídeos do YouTube com IA e lip-signi se um criador postar no Instagram ou no ingresso?

Os algoritmos estarão quentes?

A Tickets anunciou recentemente que rotularia os vídeos como “feitos ou editados” usando ferramentas de IA e também forneceria uma impressão digital para que os usuários pudessem verificar suas fontes usando equipamento de verificação C2 PA. Existe um sistema semelhante no meta-lugar. Então, qual é o destino dos vídeos editados postados em outras plataformas sociais de vídeo?

Eles serão reduzidos por algoritmos ou impedirão que apareçam em determinados feeds? A situação é um tanto complicada e inesperada. “Isso é algo que estamos observando com atenção, mas é um pouco cedo porque as plataformas fizeram declarações, mas não vimos como foram implementadas”, disse-me ele. “Normalmente, traduzimos traduções, mas não conteúdo novo.”

Usei o vídeo dos criadores, traduzindo o áudio e empurrando-os de outro canal ou plataforma sem o devido consentimento com maus atores. A dublagem automática e o AI Lip Sync tornam tecnicamente esse trabalho desonesto mais fácil de implementar, mas provavelmente não será convertido em caos total.

Kothachchi me disse: “Se sua comparação for usada em qualquer outro lugar da plataforma, você pode nos contar sobre ela e nos dizer para aceitá-la”, disse-me Kotahachchi. Dublagem automática, áudio expressivo e vídeos assinados pelos lábios serão interessantes para ver como as experiências do YouTube tornam a experiência mais diversificada. Superficialmente, parece uma vitória.

Mal posso esperar para me ver falando em espanhol, embora tenha deixado meu gênero Duolingo há alguns anos.